🗣 SL提问: ai大模型芯片

✍️ Ai批改: AI大模型芯片是专门设计用于加速人工智能(AI)计算任务的硬件芯片,尤其是在深度学习和大型语言模型训练方面。这些芯片旨在提高AI计算的效率、速度和能效,支持更复杂和更精确的AI模型。

背景

随着人工智能技术的快速发展,尤其是深度学习模型的广泛应用,对计算能力的需求急剧增加。传统的中央处理器(CPU)和图形处理器(GPU)虽然能够处理AI任务,但它们在面对大规模AI计算时,往往效率低下、能耗高。因此,专门的AI芯片应运而生,以满足日益增长的AI计算需求。

AI大模型芯片的特点

1、高并行性:AI大模型芯片通常具有成千上万甚至更多的核心,能够进行大规模并行计算,加速AI模型的训练和推理。

2、高带宽内存:为了支持大规模数据的快速访问,AI大模型芯片通常配备高带宽内存(HBM),以减少数据传输瓶颈。

3、低功耗:在提高计算能力的同时,AI大模型芯片也注重降低功耗,以适应数据中心和边缘设备的部署需求。

4、专用计算单元:一些AI芯片包含专为AI计算优化的单元,如张量核(Tensor Core),大幅提升矩阵运算能力。

主要类型

1、GPU(图形处理器):虽然GPU最初设计用于图形处理,但其并行计算能力使其成为AI计算的热门选择。现代GPU已经包含了许多针对AI计算的优化设计。

2、TPU(张量处理单元):谷歌开发的TPU专门用于加速机器学习模型,特别是针对TensorFlow和PyTorch等框架进行了优化。

3、ASIC(专用集成电路):ASIC是根据特定应用需求(如AI计算)定制设计的芯片。它们在特定任务上可以提供远超通用处理器的性能。

4、FPGA(现场可编程门阵列):FPGA可以在不改变硬件结构的情况下,通过软件编程实现不同的功能。它们被用于加速特定AI任务。

应用领域

云服务:在云数据中心,AI大模型芯片用于加速AI模型的训练和部署。

边缘计算:在智能设备、自动驾驶汽车和智能家居等场景,AI大模型芯片能够实现快速、低功耗的AI计算。

超级计算机:用于构建高性能计算集群,以支持大规模AI研究和应用。

挑战与未来

尽管AI大模型芯片取得了显著进展,但在可扩展性、编程模型、软件支持以及与现有生态系统的兼容性等方面仍然面临挑战。未来,随着技术的进步,AI大模型芯片将变得更加高效、节能,并能够支持更加复杂的人工智能模型和应用场景。

结论

AI大模型芯片的发展推动了人工智能的广泛应用和深化,支持了从自然语言处理、计算机视觉到复杂系统模拟等众多AI任务的高效执行。随着技术的不断进步,AI大模型芯片将继续在性能、能效比和适用性方面取得突破。

0

IP地址: 86.93.208.251

搜索次数: 1

提问时间: 2025-04-20 14:22:05

❓️ 热门提问:

外汇跟单app

ai快速描摹

0.01克金子多少钱

0.12克黄金多少钱

100斤黄金值多少人民币啊

黄金24k什么意思

ai答题神器免费

伦敦金 交易所

领益智造

网店ai客服

豌豆Ai站群搜索引擎系统

🤝 关于我们:

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

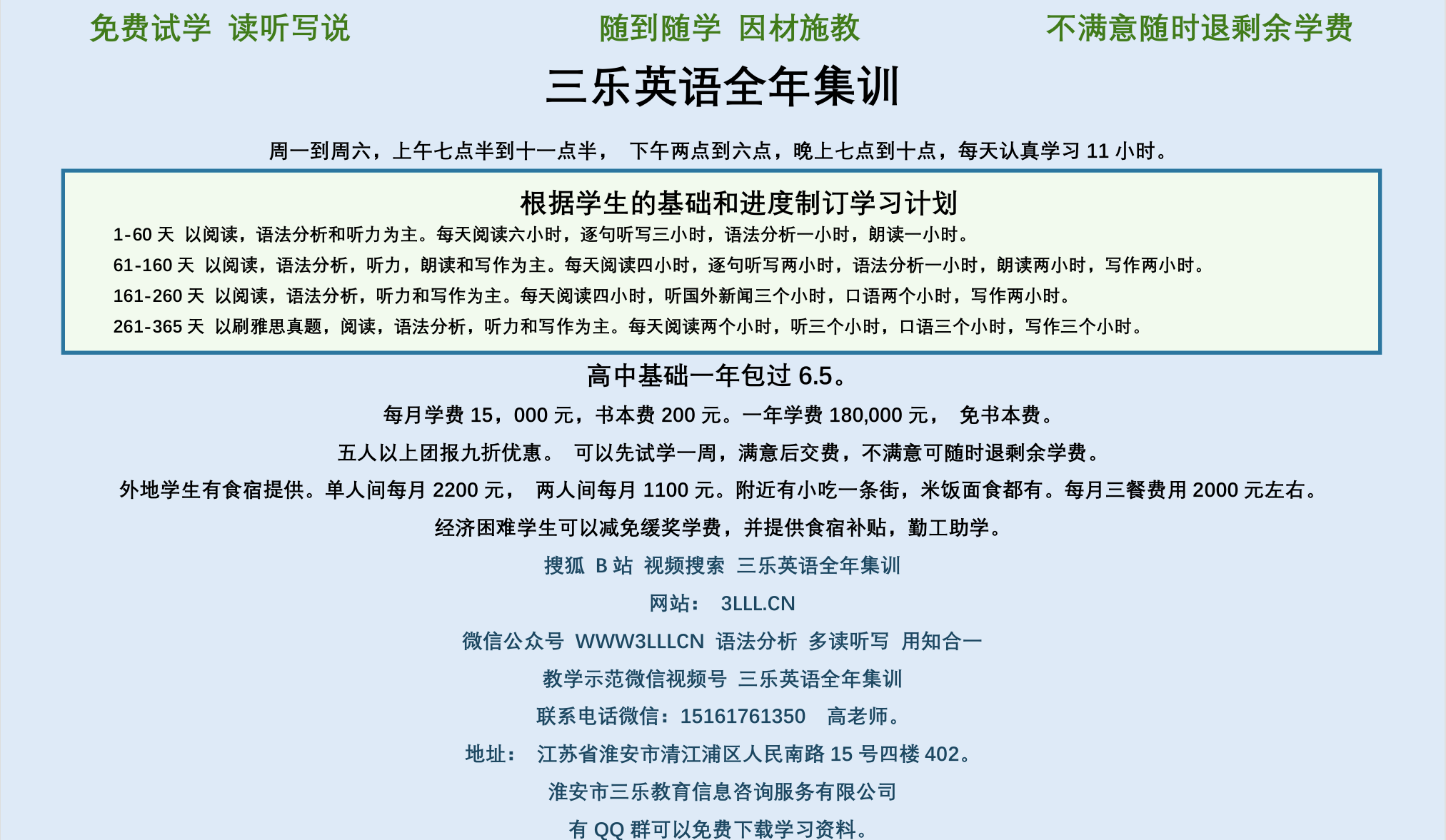

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。